¿Buscas nuestro logo?

Aquí te dejamos una copia, pero si necesitas más opciones o quieres conocer más, visita nuestra área de marca.

Conoce nuestra marca.

Conoce nuestra marca.

¿Buscas nuestro logo?

Aquí te dejamos una copia, pero si necesitas más opciones o quieres conocer más, visita nuestra área de marca.

Conoce nuestra marca.

Conoce nuestra marca.

techbiz

Antonio Jesús Rodríguez Calvente 10/12/2018 Cargando comentarios…

Hoy en día, más del 90% de las consultas se realizan a través de Google. Pero no por ello debemos obviar el resto de alternativas también muy interesantes (sobre todo en temas de privacidad) con gran potencial, como por ejemplo: Firefox, Qwant o Duckduckgo. Destacar especialmente este último sería un gran error, ya que actualmente cuenta con 30 millones de búsquedas diarias, y es un pasto verde para el SEO.

Hace unas semanas Luis Calvo nos hablaba de la importancia de que nuestra Single Page Applications (SPA) sea indexable por Google. Hoy vamos a profundizar más en cómo funciona Google (y el resto de buscadores).

Podemos definir un buscador como un sistema de recuperación de información, donde el usuario introduce una serie de palabras clave y este devuelve una serie de resultados ordenados en base a una serie de criterios.

Hoy en día, los buscadores presentan unos resultados cada vez más personalizados para cada usuario, en función del tipo de búsqueda (informativa, local, transaccional...) y en función de cientos de variables como veremos posteriormente.

Tomando por ejemplo, la búsqueda “Comprar zapatillas” vemos que se obtienen 207 millones de resultados en apenas 0,53 segundos. En este caso, los resultados se reparten entre:

Es importante mencionar que esta búsqueda se realiza contra su propia base de datos, con los resultados que tiene almacenados y ordenados según su propio criterio (su algoritmo de búsqueda).

De aquí que los resultados difieran entre buscadores y entre las versiones del propio Google, donde cada país cuenta con su propia versión del buscador (por ejemplo, Google.es para España, o Google.co.uk para Reino Unido) y su propia base de datos.

Con lo cual, para aparecer en los buscadores es condición necesaria que estos tengan almacenada nuestro contenido en su base de datos cumpliendo una serie de condiciones de rastreo e indexación y calidad para poder aparecer entre las primeras posiciones.

Antes de aparecer en los resultados de búsqueda, los buscadores realizan un proceso que se divide en tres fases, tal y como resume Matt Cutts en el siguiente vídeo:

Las tres fases que realizan tanto Google, como cualquier buscador, son las siguientes:

En la fase de rastreo los bots o arañas tratan de descubrir nuevas páginas webs y añadirlas a su base de datos. Se trata de un procedimiento continuo de descubrimiento, ya que no existe un registro central de webs.

Los bots deben seguir los enlaces de las webs que ya se encuentran en su índice, además de seguir los sitemaps que facilitamos a través de la herramienta Search Console.

Al tratarse de un ciclo continuo, los bots registran y actualizan su base de datos con las nuevas webs, los cambios realizados en ellas y eliminan los enlaces obsoletos o páginas eliminadas, siempre limitados por un “presupuesto de rastreo” que marca qué webs se deben de rastrear, su frecuencia y el número de páginas por rastreo.

Estos son algunos consejos para facilitar el rastreo de vuestras webs:

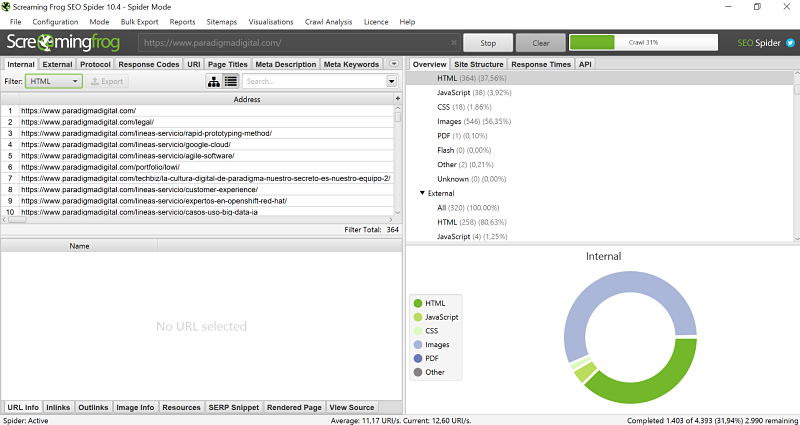

Herramientas como ScreamingFrog o Sitebuld nos pueden ayudar a la hora de identificar posibles problemas de rastreo.

Estas herramientas simulan un crawl a través de nuestra web, es decir, identifican y siguen todos los enlaces de nuestra web diferenciando entre los distintos elementos que la componen, código de respuesta, directivas que contienen, hreflang…

Se trata de herramientas muy útiles y potentes a la hora de auditar nuestra web en las primeras fases de funcionamiento del buscador (rastreo e indexación) y que disponen de un grado de personalización acorde al tipo de rastreo que deseemos en función de nuestras necesidades.

Durante la indexación los buscadores reconocen las diferentes páginas que componen un sitio web y lo almacenan en su sistema. Analizan el contenido de cada página, los recursos incluidos (vídeos e imágenes) y las meta etiquetas, como por ejemplo: Title o el “ALT” o texto alternativo de las imágenes.

El artículo de Luis al que se hacía mención al inicio del post se centra en las dificultades que presentan las Single Page Applications (SPA) y el lenguaje JavaScript en la fase de indexación, ya que si no se configuran de manera correcta los bots recibirán un HTML vacío y se ofrecen varias soluciones a este problema.

Llegados a este punto debemos destacar la importancia de la estrategia SEO que deseemos aplicar en nuestro sitio e indexar aquellas URLs con mayor potencial para los objetivos de la web.

Os dejamos algunos consejos para mejorar la indexación de la web:

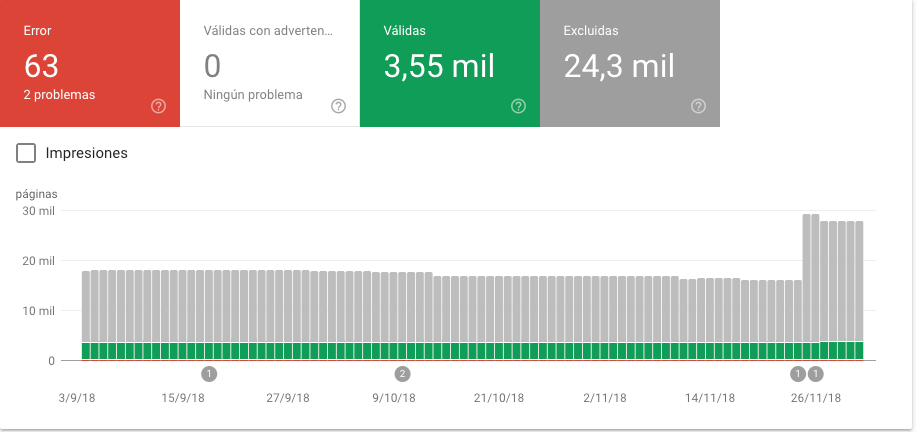

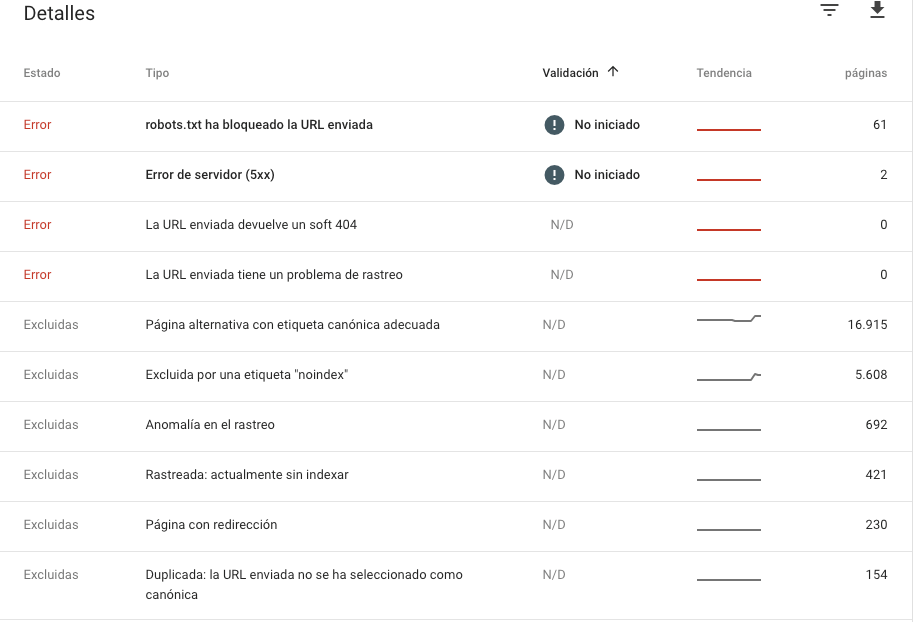

En el caso de la indexación podemos acudir al informe de “cobertura” que nos facilita Search Console, además de la herramienta “inspector de URL”, desde la que podremos analizar el estado concreto de una url.

El informe de cobertura nos ofrece una información muy valiosa del estado de nuestras URLs y los motivos que causan estos estados.

Así, por ejemplo, para los distintos errores de nuestra web, podremos saber si se tratan de errores de servidor o cliente, sí han sido bloqueadas por el archivo robots.txt o si cuentan con algún problema de rastreo que debemos de analizar en profundidad.

Esta última parte nos vuelve a llevar a la búsqueda “Comprar Zapatillas” y a los 207 millones de resultados obtenidos y concretamente la manera en que se encuentran clasificados.

El algoritmo de Google cuenta con más de 200 factores en constante actualización, que buscan presentar los resultados de la manera más acorde a la consulta del usuario con el objetivo de dar al usuario la mejor experiencia posible.

En la presentación de resultados intervienen aproximadamente 250 factores, entre los que se encuentran la ubicación del usuario, su idioma y el dispositivo desde el que se realiza la búsqueda.

En la siguiente galería de imágenes aportamos una serie de ejemplos de resultados de Google personalizados para distintos tipos de búsquedas, desde marca, personaje público, recetas a búsquedas más localizadas como la cartelera del cine o restaurantes cercanos a los que acudir.

Hasta aquí, la explicación de cómo funcionan los buscadores. En siguientes post profundizaremos en cómo trabajar nuestra web para lograr que sea amigable para los bots en las distintas fases y obtener mejores resultados en Google.

Los comentarios serán moderados. Serán visibles si aportan un argumento constructivo. Si no estás de acuerdo con algún punto, por favor, muestra tus opiniones de manera educada.

Cuéntanos qué te parece.