¿Buscas nuestro logo?

Aquí te dejamos una copia, pero si necesitas más opciones o quieres conocer más, visita nuestra área de marca.

Conoce nuestra marca.

Conoce nuestra marca.

¿Buscas nuestro logo?

Aquí te dejamos una copia, pero si necesitas más opciones o quieres conocer más, visita nuestra área de marca.

Conoce nuestra marca.

Conoce nuestra marca.

dev

Daniel Alcón 26/10/2020 Cargando comentarios…

Dicho rápido Snowflake es un data warehouse analítico en la nube (SaaS) que permite elegir con qué proveedor de servicios trabajar por debajo. La diferencia es que no está basado en las soluciones comunes de Big Data, como podría ser hadoop, sino que han generado su propio motor SQL específicamente pensando en la nube.

Esto lo asimila a herramientas existentes en las diferentes plataformas como podrían ser BigQuery en Google Cloud Platform, Redshift en AWS y Synapse en Azure. En este post vamos a ver en detalle las opciones diferenciales que nos brinda. Pero, antes, si quieres profundizar aun más en el tema aquí te contamos:

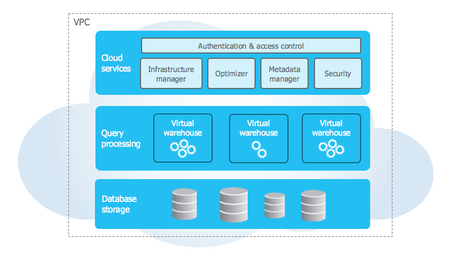

Utiliza un repositorio de datos centralizado para datos persistentes que es accesible desde todos los nodos del data warehouse, pero a la hora de procesar las consultas cada cluster guarda una parte de esos datos localmente para su procesamiento en paralelo.

Hay tres capas principales: Database storage, Query processing y Cloud services.

La capa en la que se encuentran los datos. Una vez que estos suben a la nube, Snowflake se encarga de reorganizarlos en su propio formato. Con esto consigue gestionar la organización, tamaño de fichero, estructura, compresión, metadatos, etc. para mejorar el rendimiento. Como contrapartida, estos datos solamente pueden ser consultados mediante consultas SQL a través de Snowflake.

Las consultas son realizadas por esta capa utilizando “almacenes virtuales”. Cada “almacén” es un cluster compuesto de múltiples nodos para el trabajo en paralelo, los cuales Snowflake se encarga de gestionar en el proveedor de servicios que hayamos elegido.

Es un conjunto de servicios que se encargan de coordinar las actividades de Snowflake, desde el login hasta organizar las consultas de los usuarios. Estos servicios también corren sobre instancias en el proveedor de servicios elegido, y también están gestionadas por Snowflake.

Actualmente podemos utilizar Snowflake desde:

Ahora mismo cuando te registras en Snowflake, te da la posibilidad de elegir entre tres proveedores de servicios: AWS, GCP y Azure.

Dentro de cada servicio, también tenemos la posibilidad de elegir la región en la que queremos trabajar.

Una cosa a tener en cuenta a la hora de elegir el servicio es que el coste del mismo varía en función del proveedor y de la región elegida, por lo que además de requisitos legales como la GDPR tendremos que tener en cuenta esto a la hora de elegir proveedor y región para nuestros datos.

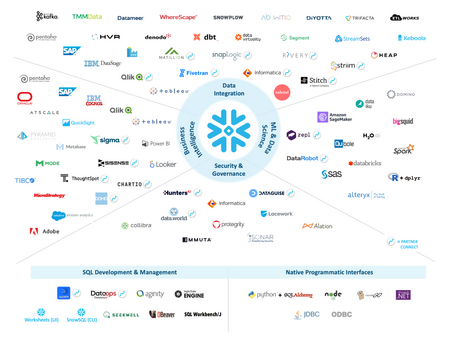

Como se puede observar en la siguiente imagen, se ha generado un buen ecosistema de integraciones alrededor del servicio que presta Snowflake, teniendo integraciones con las principales herramientas de visualización, ETL, ML, Data Science, etc.

Estas integraciones permiten entre otras cosas que en el caso de que tengamos una gran cantidad de datos en la nube y solamente queramos consultar una pequeña parte, se pueden generar consultas a “tablas externas” directamente a los ficheros en la nube.

La carga de datos debe realizarse desde lo que llaman fuentes internas, otras cuentas de Snowflake o fuentes externas, es decir S3, Cloud Storage o Azure Blobs Storage; y la tienen organizada de manera que puedes realizarla por lotes o de manera continua.

Dependiendo del volumen de datos convendrá realizar una u otra, puesto que hay ciertas diferencias, y además puede haber costes por transferencia de datos.

| Carga por lotes | Carga continua (Snowpipe) |

|---|---|

| Datos previamente en la nube | Pequeños volúmenes de datos e incremental |

| Necesidad de aprovisionamiento de DWH por parte del usuario | Totalmente autogestionado |

| Capacidades de transformación de datos simples | Capacidades de transformación de datos algo más complejas |

Además soporta la mayoría de formatos más comunes, con ciertas particularidades, por ejemplo, el formato delimitado (CSV, TSV, etc.) es el único que puede utilizar otro tipo de codificación que no sea UTF-8, pero hay que especificar explícitamente cuál es y tiene que estar soportado en esta lista.

En principio si no se trata de ficheros comprimidos, él solo se encarga de comprimir a gzip.

También soporta cifrado de los archivos. En caso de que no estén cifrados, se cifran al subirlos; y si ya están cifrados, hay que proporcionarle la clave. Como nota a tener en cuenta: para escribir el post estuvimos haciendo pruebas de subida de ficheros desde la interfaz gráfica y nos dimos cuenta que si cambiabas la pestaña del navegador se pausaba el cifrado de los datos previo a la subida.

Para finalizar esta introducción a Snowflake comentar también que las opciones de descarga de datos pasan por consultar las tablas dentro de Snowflake y guardarlas mediante el comando COPY INTO

Snowflake es una herramienta muy interesante a la hora de montar un data warehouse en la nube ya que elimina en cierta medida el vendor locking permitiendo utilizar cualquiera de las nubes con las que trabaja (AWS, GCP, Azure), disminuye y facilita las tareas de gestión de los datos con el sistema de puesta en marcha de data warehouses virtuales en cuestión de segundos para las diferentes necesidades que puedan tener los equipos que accedan a los datos, democratiza mucho el acceso a los datos al poder utilizar SQL para las consultas y, como punto final, destacar la cantidad de conectores y herramientas desde las que se puede acceder al servicio.

En otros post futuros profundizaremos en las capacidades que nos brinda el mercado de datos que es accesible desde Snowflake y otras opciones que nos ofrece la herramienta.

Los comentarios serán moderados. Serán visibles si aportan un argumento constructivo. Si no estás de acuerdo con algún punto, por favor, muestra tus opiniones de manera educada.

Cuéntanos qué te parece.